Пока что на всех ответственных должностях в человеческом мире работают люди, но совсем скоро это будет не так. В течение ближайших десяти лет появятся полностью автономные транспортные средства, системы управления и даже военные роботы. Машины вынуждены будут принимать решения — в частности, этические решения —самостоятельно. Какой морали люди должны обучить роботов, прежде чем доверить им мир? Об этом в очередной лекции цикла «Возвращение этики» говорил Дэвид Эдмондс, британский журналист и философ, автор книги «Убили бы вы толстяка?» (Would You Kill a Fat Man), ведущий подкаста Philosophy Bites на Радио BBC.

Я очень рад оказаться здесь. Спасибо за приглашение. Последний раз я был в Москве двенадцать лет назад. И, должен признаться, тогда моей задачей не был «позитивный» репортаж. Я готовил для BBC радиопередачу о коррупции в России. И в рамках этой подготовки мы отправились на выставку-презентацию «Бентли». Теперь, как мы знаем, с коррупцией в Москве полностью покончено. Так что сегодня я вновь в Москве, и мы опять будем говорить о машинах, но в несколько ином контексте. Вместо этой машины — «Бентли», я буду говорить о другом автомобиле, разработка которого обошлась почти так же дорого. Через минуту я все объясню подробнее.

Я очень признателен вам за то, что сегодня вечером вы решили прийти сюда. Надеюсь, у вас был широкий выбор, вас не затащили на лекцию о науке и механизмах под дулом пистолета. И суть жизни вообще состоит в выборе. В большинстве случаев речь строго говоря не идет о моральном выборе, хотя очень часто наши решения имеют моральные последствия. Что мне изучать — философию или медицину? Куда мне отправиться в отпуск – на юг Франции или на Черное море? Где мне сегодня поужинать – во французском или китайском ресторане? Стоит ли мне пойти на лекцию, или остаться дома у телевизора? Впрочем, важные решения всегда означают моральный выбор. Должен ли я выполнять обещания или обязательства? Можно ли лгать? Должен ли я обеспечить себе выгоду, нанеся ущерб другому человеку?

Если у вас нет выбора, вас нельзя винить за то, что вы делаете. Если я под дулом пистолета загоню вас на лекцию, а вы в это время должны ухаживать за больным родственником, вас нельзя винить за то, что вы не выполнили это обязательство. Если моя машина врезалась в вашу, а вы из-за этого сбили пешехода, вы опять же не виноваты в нанесенных ему увечьях. Моральная ответственность предполагает выбор. Ели у меня нет выбора, на меня нельзя возлагать моральную ответственность. Это, конечно, очевидно, но обычно мы считаем, что у моральной ответственности есть второй компонент, помимо выбора. Выбор не всегда, но как правило связан с намерением. Позвольте объяснить. Если моя машина врезалась в вашу, и вы из-за этого сбили пешехода, то у вас конечно не было намерения причинить ему вред. Это была не ваша вина, вы этого не хотели. И это позволяет судить о ваших действиях с моральной точки зрения. Или возьмем другой пример: если вы случайно уронили тарелку, и она разбилась, я виню вас меньше, чем если бы вы разбили ее нарочно. И если вы выстрелили в какой-то движущийся объект, думая, что это олень или буйвол, а это был человек, вы несете меньшую моральную ответственность, чем в случае, если бы вы намеренно застрелили человека.

Конечно, слова «я нечаянно» не всегда освобождают вас от ответственности. Возможно, вы пренебрегали тем, что обязаны делать. Если вы разговаривали по мобильнику за рулем «Бентли», и столкнулись с другой машиной, слова «я не хотел» выглядят слабым оправданием. Но как правило, если вы сделали что-то не нарочно, это снимает с вас часть вины. Умышленное убийство так и называется убийством, а непреднамеренное – причинением смерти по неосторожности. Во втором случае срок наказания обычно бывает меньше, чем в первом. Таким образом, выбор и намерение – это два взаимосвязанных понятия, играющие важнейшую роль в большинстве нравственных оценок, суждений о моральной ответственности. Запомните эту мысль о важности выбора и намерения, потому что я к ней еще вернусь.

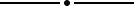

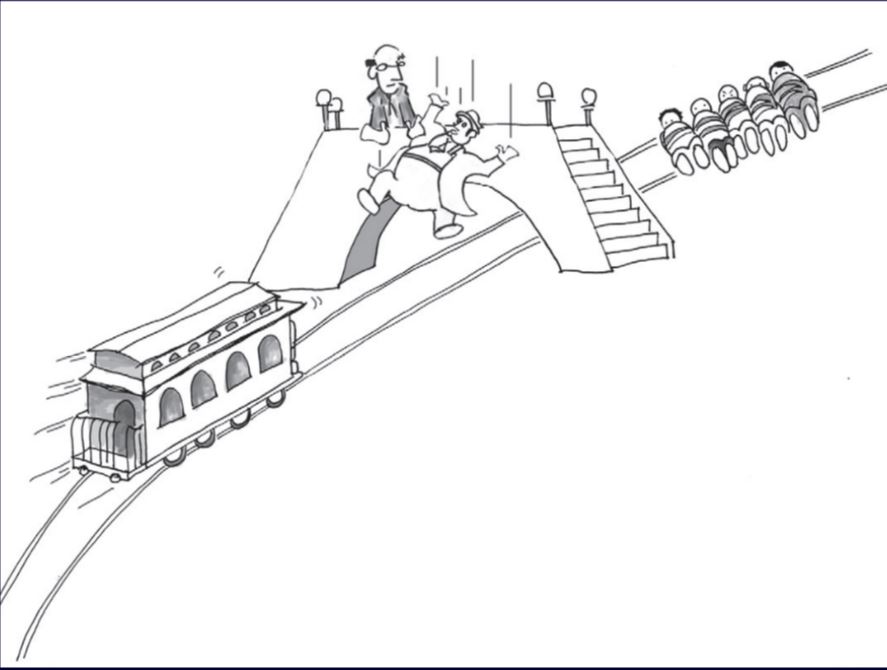

Но прежде чем мы займемся машинами, я хочу поговорить о другом транспортном средстве – поездах, и связанном с ними знаменитом мысленном эксперименте. Кто-то из вас о нем знает, а кто-то — нет. Вот здесь изображен тот мысленный эксперимент, о котором мы говорим. Позвольте объяснить, что происходит на этой картинке. Представим себе, что поезд потерял управление, у него отказали тормоза, и он движется в сторону пяти человек, лежащих на рельсах. Стрелка обозначает направление его движения – там пять человек привязаны к рельсам, и поезд идет прямо на них. Поскольку они привязаны, спастись им не удастся. Вы, конечно, спросите, а почему они не могут развязаться? Ну, в данном случае речь идет о философии, и о том, что философы называют мысленным экспериментом. И еще рядом с путями мы видим маленького лысого человечка. Это вы, и вы стоите у рычага перевода стрелки. И у меня для вас есть хорошая и плохая новость. Хорошая состоит вот в чем: если вы переведете стрелку, вы направите поезд на боковую ветку, в тупик, и спасете пять человек. Но, как видите, есть и плохая новость: на пути, ведущем в тупик, лежит человек, и он тоже привязан. Если вы переведете стрелку, один человек погибнет, а пять останутся живы. Когда я говорю об этом, мне всегда интересно попросить собравшихся поднять руки, чтобы понять, с какой аудиторией я имею дело – нормальной или весьма необычной. И вас я тоже попрошу это сделать – хочу выяснить, так же ли вы мыслите, как люди в других странах. Итак, кто из вас перевел бы стрелку? Поднимите руки, если вы это сделаете, чтобы спасти пять человек. Почти все. По-моему, это хорошо. Да, хорошо.

А кто не перевел бы стрелку?

Что ж, таких тоже немало – я бы даже сказал, необычно много. Так вот, если вы задаете этот вопрос людям по всему миру, как уже делалось в ходе сотен исследований, вы как правило получаете примерно такой же ответ, как здесь – подавляющее большинство людей, обычно до 90% аудитории, считает, что с моральной точки зрения правильно будет перевести стрелку, спасти пять жизней ценой одной. Причем демографические факторы здесь особой роли не играют. Почти все считают, что стрелку надо перевести – мужчины и женщины, богачи и бедняки, образованные и малообразованные люди, пожилые или молодежь. Даже если вы проведете тот же эксперимент с детьми, – семилетними, восьмилетними – вы получите тот же ответ. И место проведения эксперимента тоже роли не играет – один и тот же результат получается в Гонконге, Лондоне, Нью-Йорке, или, как мы сейчас выяснили, в Москве.

Этот мысленный эксперимент был придуман ученым из Оксфордского университета профессором Филиппой Фут, в 1967 году – 55 лет назад. В том году в Британии легализовали аборты, и она использовала эту ситуацию в качестве примера в своих доводах относительно аборта (какой была ее точка зрения, для нашей темы неважно). Мыслительный эксперимент с поездом стал началом длинного философского «детектива» — разные философы пытались «раскрыть преступление», ответить на вопрос, почему убивать — неправильно, как надо было поступить, и, в частности, в чем разница между этим примером и другим экспериментом, который я сейчас вам покажу. Итак, по-настоящему осложнила ситуацию через 20 лет другая женщина-философ – американка по имени Джудит Джервис Томпсон из Массачусетского технологического института. Он придумала несколько иной сценарий – вот он на картинке.

К сожалению, поезд опять неуправляем. Плохой выдался денек на железной дороге. Снова «поезд-беглец» движется к пяти людям, привязанным к рельсам. Если вы ничего не сделаете, все они погибнут. Но у вас снова есть возможность их спасти, пусть и иным способом. На этот раз вы стоите на пешеходном мосту, а рядом с вами расположился громадный, очень толстый человек. И этот толстяк свесился через перила, так что, если его чуть-чуть подтолкнуть, он свалится с моста и упадет на рельсы под ним. Сам он, увы, погибнет, но его громадное тяжелое тело остановит поезд, и пятеро лежащих на путях будут спасены. Итак, я прошу вас снова поднять руки. Кто в аудитории готов убить толстяка? Так, 20, нет, 25 рук. А кто не станет его убивать? Почти все остальные. А кто затрудняется с ответом? Один, два, три, четыре. Таким образом, несколько человек не знают, что делать, но подавляющее большинство не стало бы убивать толстяка. И это опять же соответствует результатам, полученным по всему миру. В рамках первого сценария, который я вам изложил, подавляющее большинство считает правильным перевести стрелку. А в этом, втором случае, подавляющее большинство считает неправильным сталкивать толстяка с моста. И опять же демографические факторы здесь большой роли не играют. Пожалуй, чуть больше мужчин, чем женщин считает возможным толкнуть толстяка. И опять же, результат не зависит от того, на каком языке и в каком месте вы задаете этот вопрос.

Когда я писал книгу «Убили бы вы толстяка?», мой редактор в издательстве Принстонского университета настаивал, чтобы я изменил название, потому что опасался, что меня сочтут фашистом. Но после долгих споров он все же позволил мне оставить название «Убили бы вы толстяка?», так что мне теперь надо объяснить, почему это должен быть именно толстяк. Дело в том, что мы пытаемся провести аналогию между первым примером и этим экспериментом. В обоих случаях у вас есть возможность погубить одного человека, чтобы спасти пятерых. В данном случае наиболее нравственный поступок — самому броситься с моста: так вы спасете пятерых, не убивая другого человека. Но если бы это было возможно, исчезла бы аналогия с первым примером. Поэтому здесь необходимо допущение, что вам самому бросаться под поезд бесполезно, потому что вы не настолько массивны, не настолько толсты, чтобы его остановить. Только толстяк может остановить поезд, так что вам придется убить не себя, а другого человека. Поэтому-то в нашем примере должен фигурировать именно толстяк. В наше время, последние 10-15 лет, те, кто приводят этот пример, уже не говорят о толстяке, потому что это неполиткорректно. Они говорят о человеке с тяжелым рюкзаком за плечами. Поэтому сейчас тот, кто должен остановить поезд, уже не будет толстяком — у него просто большой, тяжелый рюкзак на спине.

Что ж, вернемся к нашей загадке. На первый взгляд все здесь очевидно. В обоих случаях приходится выбирать между гибелью одного человека и пяти. Поэтому вопрос в том, чем отличаются эти два случая? Именно эту загадку мы пытаемся разгадать уже почти 60 лет. В нравственной философии главное различие — это различие между так называемыми утилитаристами (учеными, следующими традиции и британских философов XIX века Иеремии Бентама и Джона Стюарта Милля), и деонтологами. Последние привержены традиции, заложенной немецким философом Иммануилом Кантом. Утилитаристы — последователи Джона Стюарта Милля — считают: главное — это наилучший результат. Нас должно волновать, заботить то, что в максимальной степени увеличивает счастье или благосостояние людей. Что же касается этиков-кантианцев, то они полагают: важны не только результаты. К примеру, мы не должны лгать или нарушать обещания даже если это целесообразно. Мы должны говорить правду даже в том случае, если наша ложь сделала бы мир чуть счастливее. Таким образом, в философии существует конфликт между этими двумя основными традициями. И нашу загадку с толстяком утилитаристы и этики разгадывают по-разному. Утилитаристы дают простой ответ: поскольку в обоих случаях речь идет о спасении пяти жизней ценой одной, то в нравственном плане они эквивалентны, никакой разницы между ними нет, и будет в равной степени правильно перевести стрелку в первом случае и столкнуть толстяка во втором. Но по итогам вашего голосования мы только что убедились, что большинство из вас — не утилитаристы. Вы это наглядно продемонстрировали. Кое-кто из вас является утилитаристами, но подавляющее большинство к ним не относится. Очевидно, большинство из вас не убеждено однозначно, что единственно важная вещь — спасти как можно больше жизней. В противном случае вы проголосовали бы за убийство толстяка, но вы решили по-иному. Но когда вам пришлось делать первый выбор между спасением пяти жизней ценой одной, большинство из вас, так сказать, оказались утилитаристами. Вы решили, что лучше спасти пять человек, погубив одного, сравнили пятерку с единицей, и решили пожертвовать одной жизнью ради пяти. Когда же дело дошло до второго выбора, вы проявили себя не как утилитаристы, большинство из вас сочли, что было бы неправильно убивать толстяка ради спасения пяти других людей. Так вот моя книга — это попытка выяснить ответ, понять, почему эти два случая различаются. У нас сегодня слишком большая аудитория, чтобы опросить вас всех, но подумайте, в чем, на ваш взгляд, состоит эта разница, и — у нас есть время для ответов? Кто-нибудь, кто не знает эту загадку, никогда раньше о ней не слышал, хочет объяснить, в чем, по его мнению, состоит разница между этими двумя примерами, почему в первом случае мы считаем возможным убить человека, а во втором — невозможным убить толстяка?

Реплика из зала: В первом случае кто-то в любом случае должен погибнуть – один человек или много, пятеро. А во втором случае вы должны выбирать, убить кого-то или… Так что во втором случае присутствует намерение кого-то убить.

Интересный ответ. И возможно что-то в этом есть. Но на самом деле в обоих случаях вам нужно действовать. В первом случае вам надо перевести стрелку, а во втором убить толстяка. Оба раза речь идет о действиях. Разных, но действиях. Что ж, первый ответ мы выслушали, но может у кого-то есть другой ключ к разгадке?

Реплика из зала: Может быть, разница состоит в том, есть ли у вас иллюзия отсутствия ответственности за убийство одного человека? Так, во втором случае вы намеренно сталкиваете кого-то с моста, чтобы убить его, и несете ответственность за отнятую жизнь. А в первом случае к рельсам человека привязал кто-то другой.

Эдмондс: Еще одно интересное объяснение, и оно во многом похоже на первое, но напомню: в обоих случаях вы действуете, то есть речь не идет о том, чтобы убедить себя, будто вы ничего не делаете. В обоих случаях вы убиваете. Я сомневаюсь, что вы сможете убедить себя, будто не несете ответственности за смерть этого человека.

Реплика из зала: Думаю, что в первом случае все люди привязаны к рельсам, а во втором толстяк свободен, он может убежать, и от этого намерение убить его становится еще более выраженным.

Эдмондс: Что ж, все ответы очень похожи друг на друга, поскольку тот человек из первого примера, хотя и привязан к рельсам, не подвергается никакой опасности. Он привязан к рельсам, но ему ничего не угрожает. Опасность для него возникает, когда вы перевели стрелку. Толстяк тоже не подвергается опасности до того, как вы его столкнули. И человек на тупиковой ветке находится в безопасности, пока вы не пустите по ней поезд. Именно эта так интересно в связи с этими примерами: вы все даете очень похожие ответы, но очень трудно понять, почему вы дали именно такой ответ. У вас очень сильно задействована интуиция, но понять, что движет вашей нравственной интуицией, очень трудно. И философам тоже трудно это объяснить.

Думаю, вашей интуицией движет вот что. Если бы человек, привязанный на боковой ветке, смог чудесным образом спастись и убежать, а вы бы перевели стрелку, вы бы, я надеюсь, очень обрадовались, потому что вы спасли пять человек, а поезд на боковой ветке никого не задавил, все остались живы. Хорошо. Если же, с другой стороны, у толстяка на ногах окажутся сапоги на толстой каучуковой подошве, и после того, как вы его столкнули, они амортизируют падение, и он не упадет на рельсы, а убежит, вы не будете в восторге. Почему? Потому что, чтобы спасти пятерых людей, вам нужно, чтобы толстяк погиб. Если толстяк убежит, поезд поедет дальше, и раздавит пятерых людей на путях. Вам нужно, чтобы толстяк преградил путь поезду. Поэтому в первом случае вы предвидите, что будет после перевода стрелки. Кто-то погибнет, но вы не намерены убивать этого человека, и очень обрадуетесь, если ему удастся спастись. Но во втором случае вам необходима смерть толстяка, вы намереваетесь его убить. Без гибели толстяка умрут пятеро. Вы используете его, чтобы спасти пять человек. И, думаю, хотя не все со мной согласятся, именно в этом состоит важнейшее различие между двумя случаями в нравственном плане. На мой взгляд, это главное различие многое может сказать нам о других сферах «обыденной» моральной философии, например, об этике ведения войны.

Итак, как я говорил, у вас есть намерение причинить смерть толстяку, но нет такого намерения в отношении человека на тупиковой ветке. В философской литературе на этот счет приводится и другой, очень известный пример: представим себе, что в больнице пятеро пациентов нуждаются в трансплантации органов. Двоим надо пересадить почку, двоим — легкое и одному сердце. Если операция не будет сделана в течение дня, все они умрут. Органов для пересадки нет, но по счастливой случайности в больницу для ежегодной диспансеризации приходит ни в чем не повинный молодой человек с необходимой группой крови. И вопрос звучит так: должен ли врач или хирург оглушить его, убить и отдать его органы для пересадки пятерым умирающим больным? Естественно, всем нам такое предположение покажется ужасным, отвратительным. Почему? По той же причине: речь опять идет об использовании ни в чем не повинного человека в качестве средства для достижения цели. Чтобы спасти пять других людей, необходима его смерть. Вот так.

Есть ли у машины право задавить пешехода?

Вернемся к этой машине. Возможно, вы заметили, что на картинке чего-то не хватает — чего именно? Верно, водителя. Это машина управляется автоматически. Такие автомобили появятся в недалеком будущем. Никто уже не считает изображенное на картинке научной фантастикой. Крупнейшие компании мира, например, Appleи Google, уже сейчас сотрудничают с автопромом и вкладывают сотни миллионов в создание машин, не нуждающихся в водителе. Они уже проходят испытания на дорогах. В Калифорнии уже можно встретить машины Google. Немецкий автомобилестроительный концерн Daimlerиспытывает грузовики-автоматы в Невадской пустыне. По прогнозам агентства Moody’s, через 30 лет большинство автомобилей будут самоуправляемыми. Nissan, Toyota, BMW— вот лишь некоторые из крупных автомобильных компаний, публично обещающих вложить капиталы в разработку технологий автоматического вождения. На прошлой неделе, в среду, в британском парламенте было объявлено о принятии в течение четырех лет законов, позволяющих эксплуатировать и страховать такие машины. Это стало началом новой законодательной инициативы британского правительства, и поскольку здесь все конституционно, объявление сделала лично королева, приехавшая в парламент на карете. Наверно, такое возможно только в Британии: глава государства прибывает в экипаже 18 века на конной тяге, чтобы рассказать нам: скоро мы будем ездить по дорогам в автомобилях без водителей. Но в любом случае, повторюсь: машины без водителей — уже не научная фантастика.

Теоретически можно предположить, что такие машины окажутся безопаснее. Сейчас в автоавариях на дорогах мира ежегодно погибает 1,3 миллиона человек. Это почти 3300 погибших в день. Да-да, сегодня в автокатастрофах по всему миру погибло около 3000 человек. В России за 2013 год, по данным Всемирной организации здравоохранения, на дорогах погибло 27 с лишним тысяч человек. Тем не менее, прежде чем выпустить машины без водителей на наши улицы, необходимо преодолеть ряд серьезных технических проблем. Причем некоторые из этих затруднений покажутся весьма неожиданными.

Так, в настоящее время машины без водителей чересчур «законопослушны». Это было бы превосходно — если бы все машины на дорогах управлялись сами и подчинялись правилам. Но если другие автомобили, управляемые людьми, превышают скорость, и законопослушная машина-автомат пытается съехать с трассы, может случиться нечто ужасное. Поэтому в целях безопасности компьютерщикам следует запрограммировать эти машины таким образом, чтобы иногда они могли нарушать правила. Но в связи с этим возникнут дополнительные правовые проблемы, равно как и серьезнейшие сложности с созданием программного обеспечения. Представим себе, что эти проблемы уже решены — ведь, несомненно, так и будет. И еще представим, что машины без водителей будут в среднем безопаснее тех, что управляются людьми. Почему так и будет, совершенно очевидно. Машину-автомат не отвлекут муж или жена, ворчащие на заднем сиденье. Автомат не устает и не заснет за рулем. Он не выпьет пять рюмок водки на вечеринке в полной уверенности, что сможет безопасно довести машину домой.

Но речь не только о том, что машины без водителей безопасны, и позволяют людям расслабиться. Их появление даст огромный выигрыш времени и производительности труда. Нам не нужно будет самим садиться за руль, нам не понадобятся таксисты или личные водители, мы сможем просто откинуться на заднем сиденье, почитать книгу или воспользоваться электронным устройством, либо диктовать сообщения по электронной почте в телефон с системой распознавания речи. Более того, самоуправляемую машину не нужно будет на весь день оставлять на автостоянке возле офиса. Если они управляют собой сами, такими машинами можно пользоваться совместно и эксплуатировать их более эффективно. Есть и другие потенциальные выгоды. Например, когда машины управляются автоматически, они смогут ехать на меньшем расстоянии друг от друга — ведь если впереди идущий автомобиль резко затормозит, или предпримет какой-то другой неожиданный маневр, они не зависят от человека с его медленной реакцией. Это позволит резко сократить дорожные пробки. Наконец, такие машины несут в себе гигантские социальные преимущества. Скажем, есть люди, которые не могут водить машину. Допустим, они страдают эпилепсией или просто слишком стары, чтобы садиться за руль. При определенном образе жизни отсутствие машины может ощущаться весьма болезненно — люди по сути оказываются в изоляции, без общения. И эту проблему машины без водителя тоже позволят решить.

Однако, несмотря на весь этот потенциальный выигрыш в плане безопасности, экономическую выгоду и пользу для общения, как минимум некоторое время будет существовать одна проблема. И эта проблема столь сложна, что, на мой взгляд, из-за нее внедрение полностью автономных автомобилей может затянуться дольше, чем хотели бы их изготовители. По сути она не носит технического характера. Это — этическая проблема. Для нее у меня нет четкого решения, но она несомненно станет одним из самых серьезных этических вызовов нашего времени.

Для простоты дадим автомобилю без водителя имя. Назовем его Мишей. Так вот, суть проблемы состоит в следующем: убьет ли Миша толстяка? Или скажем по-другому: допустим Миша со скоростью 50 миль в час везет пассажира в магазин. Внезапно перед ним на полосу сворачивает мотоцикл с двумя людьми. У Миши есть три варианта действий. Он может резко свернуть влево, но так он врежется в стену, и пассажир, которого он везет, погибнет. Он также может ехать дальше, и задавить двоих на мотоцикле, или повернуть вправо, но тогда он задавит ребенка.

Оставим пока в стороне вопрос, на какие действия следует программировать Мишу. До этого надо ответить на другой вопрос: кто должен принимать решение? Кто должен решать, что в такой ситуации следует делать Мише: повернуть влево, вправо или ехать прямо? Здесь есть несколько вариантов. Возможно, решение должны принимать законодатели, парламент. Или его следует делегировать производителям — может быть, Googleили Daimlerдолжны выбрать, как программировать Мишу и другие машины-автоматы. А возможно решение следует оставить за владельцем. К примеру, когда вы приходите в автосалон, вам показывают разные машины. Миша, объясняют вам, — это отличный утилитарный «хэтчбэк», который всегда будет сводить к минимуму количество погибших в аварии. А вот рядом стоит Владимир — прекрасный кантианский кабриолет. Он не всегда будет действовать так, чтобы число жертв было наименьшим. Какую из машин вы хотите купить? Кстати, мысль оставить решение за владельцем не такая дикая, как кажется. В конце концов сейчас все решения в рамках закона принимает водитель. При столкновении на большой скорости водитель с большей вероятностью может погубить себя и других, и именно он определяет, каким должно быть соотношение между быстротой и безопасностью. Некоторые выбирают высокую скорость, чтобы быстрее достичь места назначения, хотя это слегка увеличивает риск для них самих и окружающих. Так почему же не предоставить владельцу выбор той или иной этики своего автомобиля?

Однако в нашей жизни ответственность — это правовое обязательство. Если производитель или покупатель решает, какой моральный кодекс занести в компьютер, то ему же нести за это решение юридическую или хотя бы нравственную ответственность. Представим себе, что Миша повернул вправо и убил ребенка, но уберег двоих на мотоцикле. Смогут ли родители ребенка подать в суд на Мишу или его владельца? Если владелец Миши выбрал утилитарную машину, то родители несомненно привлекут его к ответственности. Если этический алгоритм для программирования своих автомобилей выбирает Google, родители тоже будут знать, с кем судиться. Конечно, многое говорит в пользу единообразия при программировании таких машин. Если все они работают одинаково, каждому автомобилю будет легче спрогнозировать реакцию других машин на определенные ситуации. Если же они не знают, что за автомобиль едет перед ними, — кантианец или утилитарист — затруднения сильно увеличиваются, и проблемы решить становится нелегко. Вероятно, будут найдены способы передачи такой информации, возможно, стикер на заднем стекле с надписью: «эта машина с гордостью сообщает, что действует строго по правилам утилитаризма».

Но надо решить еще один вопрос. Какой вес следует придавать жизням тех, кто находится в машине? Вспомним варианты действий Миши, и сосредоточимся на двух первых. Если Миша продолжит движение вперед, погибнут двое на мотоцикле. Если он свернет влево, погибнет его собственный пассажир. Таким образом, Миша может пожертвовать жизнью пассажира, чтобы спасти двух других людей. С точки зрения утилитаризма, это был бы оптимальный выбор: одни человек погиб, двое спасены. А теперь я снова попрошу вас проголосовать. Кто из вас купить машину-автомат, которая пожертвует вашей жизнью ради безопасности других?

Один, два, три, четыре, пять, шесть, семь. Восемь! Таким образом, восемь человек готовы пожертвовать собой, чтобы спасти других. А теперь поднимите руки – кто из вас не купит машину без водителя, которая пожертвует вами ради спасения других жизней? Вы – люди вроде меня, эгоисты. Я еще никогда не проводил этот тест, никогда раньше не говорил на эту тему, но именно такое решение подсказывает мне интуиция. Я никогда не куплю машину-автомат, которая пожертвует моей жизнью ради других.

Есть, кстати, еще одно затруднение, о котором я даже не упомянул. Речь вот о чем: готов ли Миша пожертвовать пассажиром независимо от того, кто виноват в сложившейся ситуации? Мотоцикл мог оказаться прямо перед Мишей по самым разным причинам. К примеру, он мог наехать на большой камень и потерять управление. Или водитель был пьян, и бесшабашно лавировал в потоке. В общем, у меня интересный вопрос для тех, кто готов пожертвовать собой: вы пойдете на это даже в том случае, если во всем виноват водитель мотоцикла? Вы действительно готовы умереть, если пьяный мотоциклист сам подверг риску собственную жизнь и жизнь своего пассажира? Сомневаюсь. Так что, если мы придаем какой-то вес нашей нравственной интуиции, вывод заключается в том, что «этическая» программа, управляющая Мишей, должна иметь механизм, определяющий вину. И проблема с включением в компьютерную программу понятий вины и ответственности необычайно сложна. Впрочем, как мы только что убедились, мало кто из вас купит Мишу, если он готов пожертвовать вами ради других, независимо от того, виновен ли мотоциклист в аварийной ситуации. Меня не удивляет, что интуиция говорит вам то же, что и мне, но это трудно назвать полностью рациональным. Позвольте привести вам пример.

Сегодня почти во всех странах возник кризис с донорскими органами: люди умирают, потому что не хватает органов для пересадки — сердец, легких, почек и так далее. Сорок лет назад один философ-утилитарист предложил такое решение проблемы: почему бы не организовать нечто вроде лотереи органов для трансплантации? Разве не отличная идея — присвоить нам всем номера, и сложить их в шляпу? Каждый взрослый человек будет иметь свой номер, и каждый месяц из шляпы будут вытаскивать несколько бумажек с номерами. Тех, чьи номера выпали, будут безболезненно умерщвлять, а их почки, сердца и легкие удалять и использовать для спасения больных. За счет одной жизни можно таким образом спасти пять. На первый взгляд, подобная система обоснована. В конце концов, каждый из нас может внезапно заболеть и нуждаться в пересадке органов. Сейчас донорского органа мы в этом случае можем не дождаться. А с этой радикальной лотерейной системой есть крохотный шанс, что мой номер выпадет и меня убьют, но на деле система с большей вероятностью спасет мою жизнь, и в целом умирать будет меньше людей.

Мы, конечно, не сможем на это согласиться. Поэтому, если машина без водителя готова пожертвовать пассажиром, чтобы спасти большее количество людей, это, наверно, абсолютно рациональное решение. Только никто не хочет оказаться в машине, которая может так поступить. Возможно, мы не против купить машину, которая будет таким образом взвешивать жизни незнакомых нам людей, которая решит, что лучше убить одного незнакомца, чем двоих, но когда она производит такие расчеты с нашей собственной жизнью, нам это не понравится.

Работа над искусственным интеллектом продвигается семимильными шагами. В Лондоне есть потрясающая компания под названием DeepMind: ее только что приобрел Googleза 600 миллионов долларов. Несколько месяцев назад DeepMindсоздала компьютерную программу, добившуюся того, что многие считали неимоверно трудной задачей — выиграть у чемпиона мира по игре в го, которая считается более сложной, чем шахматы. Это еще одно доказательство непрерывного и потрясающего прогресса в развитии искусственного интеллекта. Но обыгрывать людей в шахматы или го — это одно, а взвешивать моральные суждения — дело куда более сложное и неоднозначное.

Возьмем опять же поездку на машине без водителя, которая готова пожертвовать вашей жизнью для спасения двух других. Очевидно, даже это — не абсолютное правило. Поэтому мы можем счесть приемлемым, если такая машина спасает жизнь пассажира, даже если при этом погибнут двое других людей. Но мы наверняка будем возмущены, если в нашей жизни появятся машины без водителей, которые ради спасения пассажира способны врезаться в большую толпу, убив десятки людей. Конечно, большая часть работы над будущими машинами-автоматами ляжет на плечи инженеров, а не специалистов по моральной философии. Инженеры смогут делать эти машины все более безопасными, совершенствуя тормозную систему, сокращая время реагирования и так далее. Но стопроцентно безопасен только тот автомобиль, что стоит в гараже без движения. Поэтому-то «моральных» правил управления машиной-автоматом не избежать.

Изменят ли роботы нашу мораль?

Что же нам делать? Как решить эту проблему? Попробую сделать радикальное гипотетическое предположение. Почти все в этом зале и почти все на нашей планете, кому приходилось отвечать на соответствующий вопрос, считают, что убивать толстяка неправильно. Но я утверждаю: когда речь заходит о машинах-автоматах, мы думаем иначе. Я пока не убежден, что нам и следует думать иначе, но, когда эти машины станут реальностью, мы, как я полагаю, начнем думать иначе, наша интуиция станет куда более утилитарной. Особенно когда дело касается отношения пассажиров к посторонним людям. Не думаю, что люди захотят сесть в машину, которая приравнивает жизнь своего пассажира к жизни случайного прохожего. Но когда дело доходит до выбора, – ехать дальше и убить двоих, или повернуть вправо и убить одного — мы захотим, чтобы наши машины старались свести к минимуму число жертв, чтобы они действовали утилитарно. Почему я так думаю?

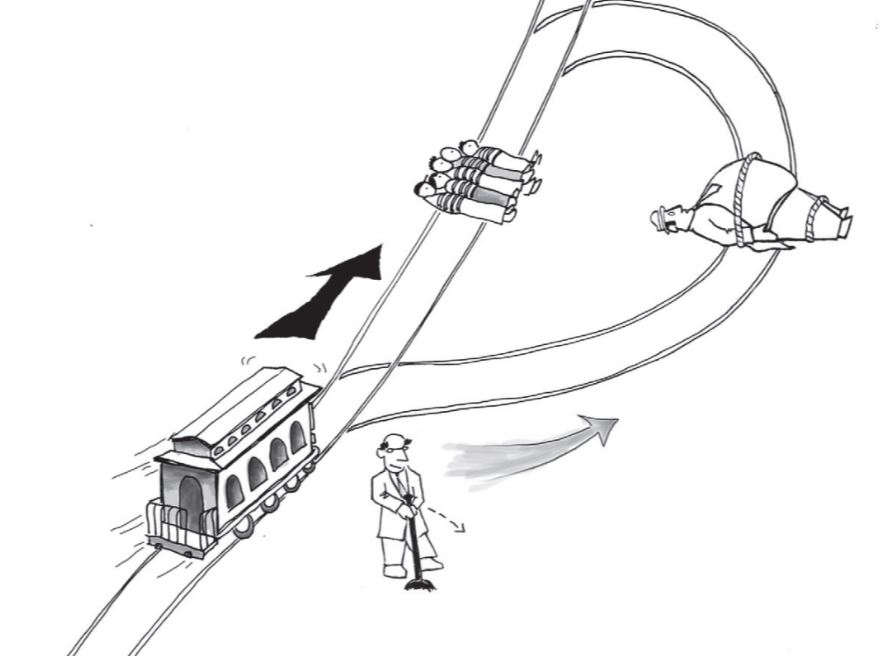

Рассмотрим другой вариант примера с толстяком — его до сих пор не было в литературе. Что мы видим на картинке? Это снова поезд, потерявший управление, который должен задавить пять человек, привязанных к рельсам. И у вас опять есть возможность пустить его по другому пути. К этому пути тоже привязан человек — крупный, массивный, толстый. Если поезд столкнется с ним, он остановится, но человек при этом погибнет. В общем, все похоже на первый пример, но есть одно различие. Путь, к которому привязан толстяк — не просто боковая ветка: это петля протяженностью в несколько метров. Как это меняет ситуацию в моральном плане? Ну, если мое объяснение верно, причина, по которой в первом случае мы поступаем правильно, переведя стрелку, а во втором — не сталкивая толстяка, заключается в том, что в ситуации с толстяком мы используем его смерть, чтобы спасти пять жизней, но в изначальной ситуации с боковой веткой мы не используем смерть одного человека, чтобы спасти пять других. Если в первом случае человеку, привязанному к боковой ветке, удастся сбежать, вы будете рады, что никто не погиб. Но если сбежит толстяк, это вам не понравится. Чтобы пятеро спаслись, толстяк должен умереть. А что же с третьим случаем, который я только что описал?

Внешне он напоминает первый случай, но по сути ближе к ситуации с толстяком. Почему, спросите вы? Что ж, представим, что толстяк или человек из третьего примера сбежит, когда вы переведете стрелку. Это будет плохой исход, потому что тогда поезд преодолеет петлю и задавит пятерых на рельсах. Если и есть какое-то основание для перевода стрелки, то это наличие человека на рельсах петли. Он вам нужен, чтобы спасти пять жизней. Так? Поэтому, если я правильно трактую человеческую мораль, то в случае с петлей переводить стрелку было бы неправильно, поскольку человек, лежащий на рельсах, стал бы средством для спасения пятерых других. Мы намерены причинить ему смерть, нам нужно, чтобы он погиб. Но намерение — это нечто осознанное, его может иметь только человек или животное, а у куска металла или силикона намерений не бывает. Кусок железа остается куском железа, механизмом, даже если он превращен в «Бентли» или машину-автомат Google. Да это очень сложный механизм, но все же механизм. А поскольку говорить о моральной ответственности автомобиля бессмысленно, представляется абсолютно логичным запрограммировать его так, чтобы свести к минимуму количество погибших, неважно каким способом.

Конечно, машины-автоматы не программируют себя сами. Их будут программировать люди, осознающие последствия различных алгоритмов. Таким образом, эти программы намеренно нацеливаются на определенный результат. Но в ходе эксплуатации решения принимают машины-автоматы. Таково одно из свойств искусственного интеллекта. На этом этапе программа изымается из процесса, и чем больше развит искусственный интеллект, чем больше компьютеры обретают способность учиться самостоятельно, тем удаленнее от решений оказывается программа. Понимаете, механизмы будут принимать решения, которые в их программе даже не спрогнозированы. И вот мое мнение: мы не просто согласимся с тем, что машины будут конструироваться таким образом, чтобы свести к минимуму число человеческих жертв — любой другой вариант покажется нам возмутительным. Если машина без водителя убила двух человек, а альтернативой была бы смерть одного, родственники погибших будут разгневаны и, вполне возможно, вправе обратиться в суд.

Я сейчас сосредоточиваюсь на машинах, но с такими же дилеммами мы вскоре столкнемся и в ряде других областей. Более того, наша жизнь и сегодня уже во многом определяется искусственным интеллектом. Чаще всего в этой связи приводится пример с кредитной картой. Компьютеры, управляющие кредитными картами, уже достаточно «умны», чтобы принимать решения санкционировать типичную трансакцию и не пропустить то, что выглядит очень странным. Скажем если я, лондонец, вдруг попытаюсь купить в Москве что-то очень дорогое, кредитной картой мне воспользоваться не удастся. И, конечно, сюда я летел в самолете, где есть пилот, но почти все решения, кроме моментов взлета и посадки, принимает компьютер. В нашей жизни есть и другие сферы, где искусственный интеллект начинает играть определенную роль. И этих сфер, судя по всему, будет все больше и больше.

Один из примеров — беспилотники в небе над Пакистаном, охотящиеся на исламских боевиков. Сейчас ими управляют молодые люди из центра в Невадской пустыне. Многим из вас случалось играть в компьютерные игры. Так вот они точно так же двигают джойстики и нажимают кнопки, и убивают людей в тысячах миль от себя. Им говорят, кого нужно уничтожить, и они решают, когда нажать на кнопку. У них есть власть над человеческими жизнями, они определяют, кто погибнет, а кто останется в живых. При этом, как мы знаем, они порой совершают ошибки. Иногда, неправильно определив цель, они убивают ни в чем не повинных людей. Военные утверждают, что, несмотря на эти трагедии, подобная система порождает меньше ошибок и «побочного ущерба», используем здесь это жуткое выражение, чем традиционные боевые действия. Тем не менее по ряду причин в будущем скорее всего все меньше решений будут принимать молодые люди в Неваде, и все больше — сами беспилотники в ходе патрулирования. Они будут решать, когда выпускать ракеты, когда открывать огонь. И опять же, есть веские основания, чтобы приветствовать такой оборот событий. Солдаты, даже те, кто сидит в креслах в Неваде, устают, им может хотеться пить, у них могут быть личные неприятности. На решения, принимаемые машинами, случайные факторы влияют меньше. Тем не менее, с автономными беспилотниками возникнут те же дилеммы, что и с машинами без водителя.

Или еще один пример. Сейчас, если вы лежите без сознания на больничной койке, решения о наилучшем способе лечения принимает человек — врач. Для этого необходимо взвесить ряд сложных факторов. Но в будущем эти решения сможет принимать врач-робот, и возможно благодаря более правильным, надежным суждениям такой робот спасет много жизней. Но опять же вы столкнетесь с ситуациями неизбежного морального выбора.

Различие, о котором мы сегодня говорили — между намерением и предвидением — заложено и в Женевскую конвенцию. Если командующий армией, отдавая приказ об ударе по важной и законной военной цели, предполагает, что при этом вероятно погибнет сотня мирных людей, живущих рядом с ней, его нельзя обвинить в военном преступлении, если речь действительно идет о законной цели. Однако если он намеренно наносит удар по гражданским лицам, это квалифицируется как военное преступление. Аналогичным образом, если врач вводит больному смертельную дозу морфия, намереваясь его убить, его обвинят в убийстве независимо от того, насколько серьезно был болен пациент. С другой стороны, если врач введет безнадежному пациенту морфий в качестве обезболивающего, зная, что побочным эффектом этого наркотика может стать смерть человека, его действия считаются допустимыми. В этих примерах, связанных с армией и медициной, различие между намерением и предвидением одинаково — оно позволяет нам отличить военное преступление от законной военной операции, или убийство от легитимной помощи безнадежным больным в медицине. Но намерение — это свойство человеческого мышления, это понятие не имеет или почти не имеет смысла применительно к автономным военным беспилотникам и самостоятельным роботам-врачам.

В заключение вернемся к толстяку. Большинство из нас считает, что убить его было бы неправильно. И причина, на мой взгляд, заключается в том, что мы считаем неправильным использовать человека как средство для достижения цели. Однако в программы самостоятельных автомобилей и роботов надо встраивать некий моральный кодекс. И мой прогноз заключается в том, что мы — потребители и граждане — со временем сочтем утилитарные решения не только приемлемыми, но и единственно возможными. Иными словами, мы придем к убеждению, что эти машины должны любым способом сводить ущерб к минимуму. Это будут очень важные решения, и рано или поздно их придется принимать. Однако я думаю, что, когда речь зайдет о машине, мы коллективно придем к выводу, что толстяка убить можно. Спасибо за внимание.